반응형

0. Abstract

- 최근 text-to-image 생성 모델은 다양한 시각적인 창의성을 발휘할 수 있도록 했지만 스토리 시각화, 게임 개발, 에셋 디자인, 광고 등과 같은 실생활 문제들에 적용될 수 있는 일관된 캐릭터 (consistent character) 생성에는 어려움이 있음

- 본 논문에서는 일관된 캐릭터 생성을 자동으로 수행할 수 있는 기법을 제안

- 입력으로는 오직 텍스트 프롬프트만을 사용

- 반복적인 과정을 수행하며 각 단계마다 유사한 특성을 가지는 연관된 이미지 세트를 식별하고 해당 세트로부터 일관된 특성을 추출

- 정량적 결과에서 프롬프트 일치도와 특성 유지 사이에서 기존 베이스라인 기법들보다 더 균형있는 결과를 보임

1. Introduction

- Text-to-Image 생성 모델의 능력은 갈수록 인상적으로 되고 있지만 해당 모델들이 이렇게 일관적인 생성을 하는 것은 어려운 문제

- 본 논문에서는 일관된 캐릭터 생성 (consistent character generation)을 수행하는 연구를 수행 → 캐릭터를 설명하는 텍스트 프롬프트만 입력하면 동일한 캐릭터를 새로운 상황에서 생성하는 것이 가능하도록 함

- (위쪽 줄) 그림과 같이 “점토로 된 고양이 캐릭터”의 그림을 생성한 경우 최신의 text-to-image 모델로 캐릭터를 설명하는 프롬프트를 사용해도 다양한 결과를 도출하며 일관성이 부족한 모습을 보임

- (아래쪽 줄) 본 논문의 기법은 고양이의 일관된 표현 (representation)을 정제하여 동일한 캐릭터가 여러 다른 장면에서 묘사될 수 있도록 함

- 연구의 가정

- 특정 프롬프트에 대해 충분히 큰 생성 이미지 세트가 있고 공통의 특징을 가지는 이미지의 그룹들을 포함

- 특정 군집이 주어졌을 때 이미지들 사이에서 “공통점”을 파악할 수 있는 특징 추출이 가능해야함

- 위 가정의 과정을 반복하다보면 입력 프롬프트에 대한 충실도는 높으면서도 생성된 이미지들 간의 일관성을 향상시킬 수 있음

2. Method

- 본 기법의 목표 → 텍스트 묘사를 기반으로 특정 캐릭터에 대해 일관된 이미지를 생성하는 것

- 모델에 의해 생성된 이미지의 세트 자체를 학습 데이터로 사용하여 반복적으로 사전학습 된 text-to-image 모델을 학습

- 모델의 출력으로부터 일관된 특징을 반복적으로 정제하여 타겟 캐릭터의 표현을 구체화제안된 기법의 구현 과정

- 해당 과정이 수렴하면 결과적으로 취득한 모델은 새로운 장면에서 타겟 캐릭터의 일관된 이미지를 생성하는데 사용될 수 있음

- 제공된 텍스트 프롬프트를 기반으로 다수의 이미지를 생성

- 사전학습된 특징 추출 모델 (여기서는 CLIP) 을 사용하여 이미지를 유클리드 공간에 임베딩

- 해당 임베딩들을 군집화 → 가장 응집된 (cohesive) 군집을 개인화 (personalization) 기법의 입력으로 사용 → 일관된 특징을 추출하도록 학습

- 그리고 학습이 진행된 모델을 사용하여 텍스트 프롬프트를 묘사하면서도 일관성이 향상된 다수의 이미지를 다시 생성

- 위 과정을 수렴할 때까지 진행

- 군집 C의 응집도는 중심 C$cen$과 C를 구성하는 각 요소들의 사이의 거리의 평균으로 결정

- 이미지를 프롬프트를 주어 생성하고, 그 결과들을 군집화하고, 군집의 중심에서 얼마나 떨어져있는지를 구함.

3. Qualitative and Quantitative Comparison

- 본 논문의 기법을 기존의 개인화 기법들과 비교

- 각 실험에서 각 기법들은 입력 프롬프트 p로부터 SDXL을 통해 생성된 단일 이미지에서 특징을 추출하는 방법을 사용

- Textual Inversion (TI)

- 동일한 컨셉의 몇장의 이미지로 텍스트 토큰을 최적화 → SDXL의 두 텍스트 인코더에 대해 2개의 텍스트 토큰을 학습하여 변환

- LoRA DreamBooth (LoRA DB)

- 일반적인 DB보다 오버피팅이 덜 발생함

- 이미지 인코더 기반 기법들과도 성능 비교

- 단일 이미지를 확산 모델의 텍스트 공간으로 인코딩하여 새로운 장면에서 대상을 생성

- 기법: BLIP-Diffusion, ELITE, IP-adapter

- TI, BLIP-Diffusion, IP-adapter는 프롬프트를 따라 이미지를 생성하지만 캐릭터의 일관성을 잘 유지하지 못함

- LoRA DB의 경우 일관된 생성은 잘 하지만 캐릭터가 동일한 포즈로 고정되어 버림

- ELITE는 프롬프트를 잘 따르지 못하고 생성된 캐릭터가 변형되어버림

- 본 논문의 기법의 경우 일관성도 유지하면서 다른 포즈나 각도 등에서 생성을 잘 수행함

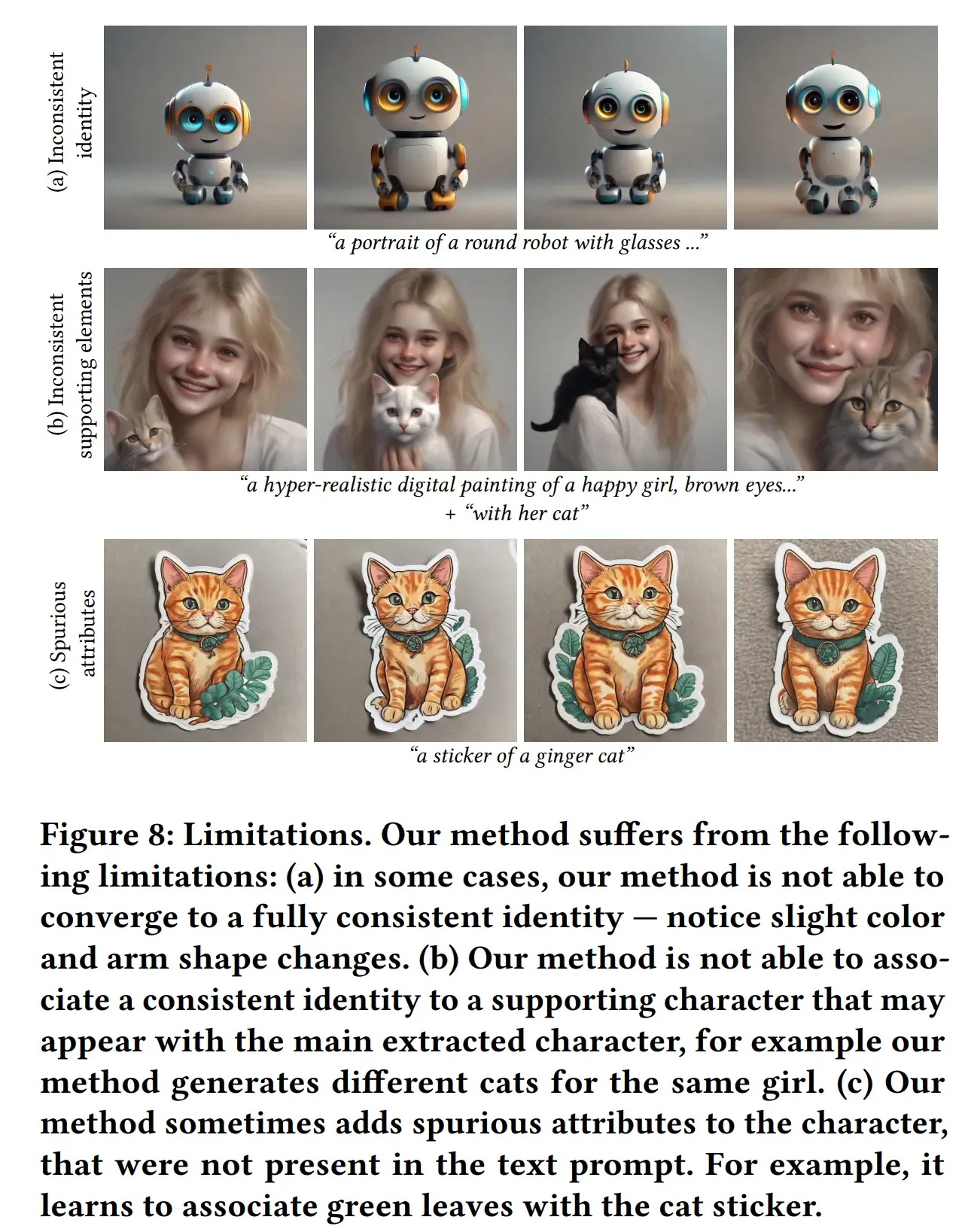

4. Limitations and Conclusions

- (a) 일관되지 않은 특징

- 특정 경우에서 완전히 일관적인 특징으로 수렴하지 못함

- 그림(a)를 보면 로봇 그림에서 색이나 모양이 다른 경우들이 종종 발생

- 이는 프롬프트가 너무 일반적이어서 특징을 군집화할 때 충분히 응집된 세트를 찾지 못해서 발생하는 것으로 생각됨

- (b) 일관되지 않은 추가적인 대상

- 입력된 캐릭터 외에 다른 캐릭터가 추가되는 경우 (e.g. 입력 캐릭터의 애완동물) 일관적이지 않은 특성을 보임

- 그림(b)를 보면 프롬프트에서 한 여자아이와 그녀의 고양이를 생성하도록 요청 → 다른 고양이들이 생성되는 것을 확인할 수 있음

- (c) 가짜 특성들

- 입력 프롬프트와 관계 없는 추가적인 특성들이 함께 생성되는 경우

- 그림 (c)를 보면 입력 프롬프트는 “황갈색 고양이의 스티커”지만 생성된 스티커에 계속 초록색 잎들이 추가된 겻을 확인할 수 있음

- 이는 특징 군집화 단계에서 가장 응집된 군집인 ccohesive에 잎들이 있어서 추가된 것으로 생각

- 이를 피하기 위해서는 자동적으로 군집을 선택하는 것이 아니라 사용자가 직접 선택하는 방법이 있음

- 엄청난 계산량

- 본 기법의 각 단계는 많은 이미지 생성, 가장 응집된 군집의 특성 학습을 포함

- 일관된 특성으로 수렴하는데 약 20분 소요

- 단순화된 캐릭터

- 본 논문의 기법은 단순한 장면들을 생성할 수 있음 (중심에 위치한 단일 객체)

- 이는 특징 추출 단계의 “평균” 효과에 의해 발생

결론적으로, 이 연구는 단일 텍스트 프롬프트만으로 반복적 이미지 생성과 군집화를 통해 일관된 캐릭터를 생성할 수 있음을 보여줍니다. 다만, 파운데이션 모델에서 생성된 이미지를 초기 입력으로 사용하기 때문에, 사용자가 원하는 특정 캐릭터의 세밀한 특징을 직접 지정하기 어렵다는 한계가 있습니다.

이로 인해 프롬프트가 모호하면 불필요한 부가 특성이 반영되거나, 원래 의도와 다른 이미지가 생성될 가능성이 높아 사용자 개입이나 추가적인 커스터마이징이 요구됩니다. 또한, 이러한 과정이 계산량 측면에서 자원적으로 상당한 부담을 주어 실시간 응용에는 개선이 필요해 보입니다.

'paper review' 카테고리의 다른 글

| Multi-Concept Customization of Text-to-Image Diffusion 리뷰 (0) | 2025.03.04 |

|---|---|

| Prompt-to-Prompt Image Editing with Cross Attetion Control 리뷰 (0) | 2025.02.24 |

| HyperClova X Technical Report (0) | 2024.04.11 |

| Direct Preference Optimization: Your Language Model is Secretly a Reward Model논문 리뷰. (0) | 2024.03.12 |

| Large Language Models for Data Annotation: A Survey 논문 리뷰 (1) | 2024.03.05 |